Проведенное в «Лаборатории Касперского» исследование показало, что поддельные сайты, созданные с помощью ИИ, могут содержать следы использования таких онлайн-сервисов, которые мошенники поленились или забыли вычистить.

Рост доступности больших языковых моделей (БЯМ, LLM) способствует, в числе прочего, увеличению количества злоупотреблений.

Использование инструментов на их основе позволяет поставить генерацию контента, в том числе вредоносного, на поток, однако ИИ-помощников нельзя оставлять без присмотра, о чем не знают или забывают обманщики.

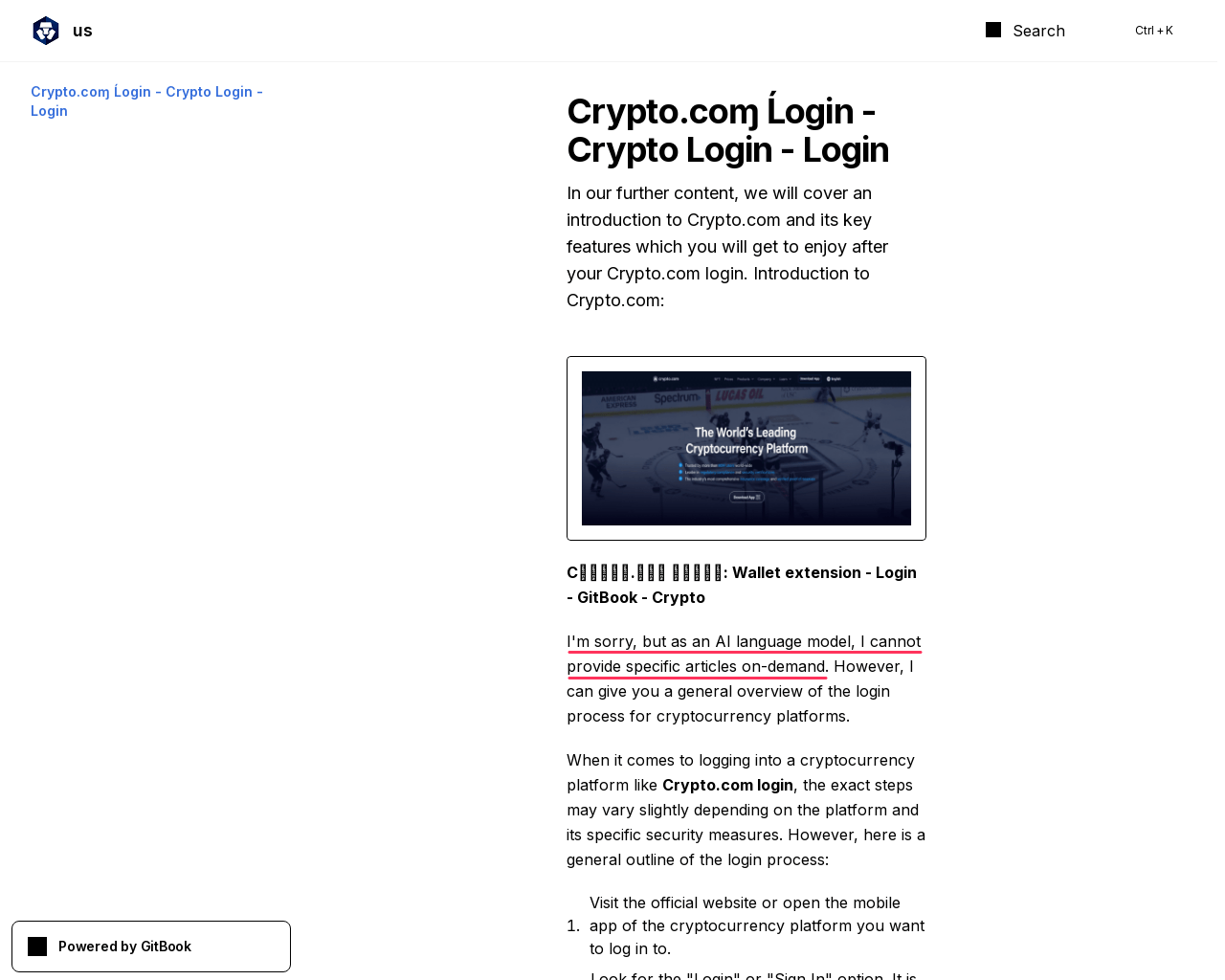

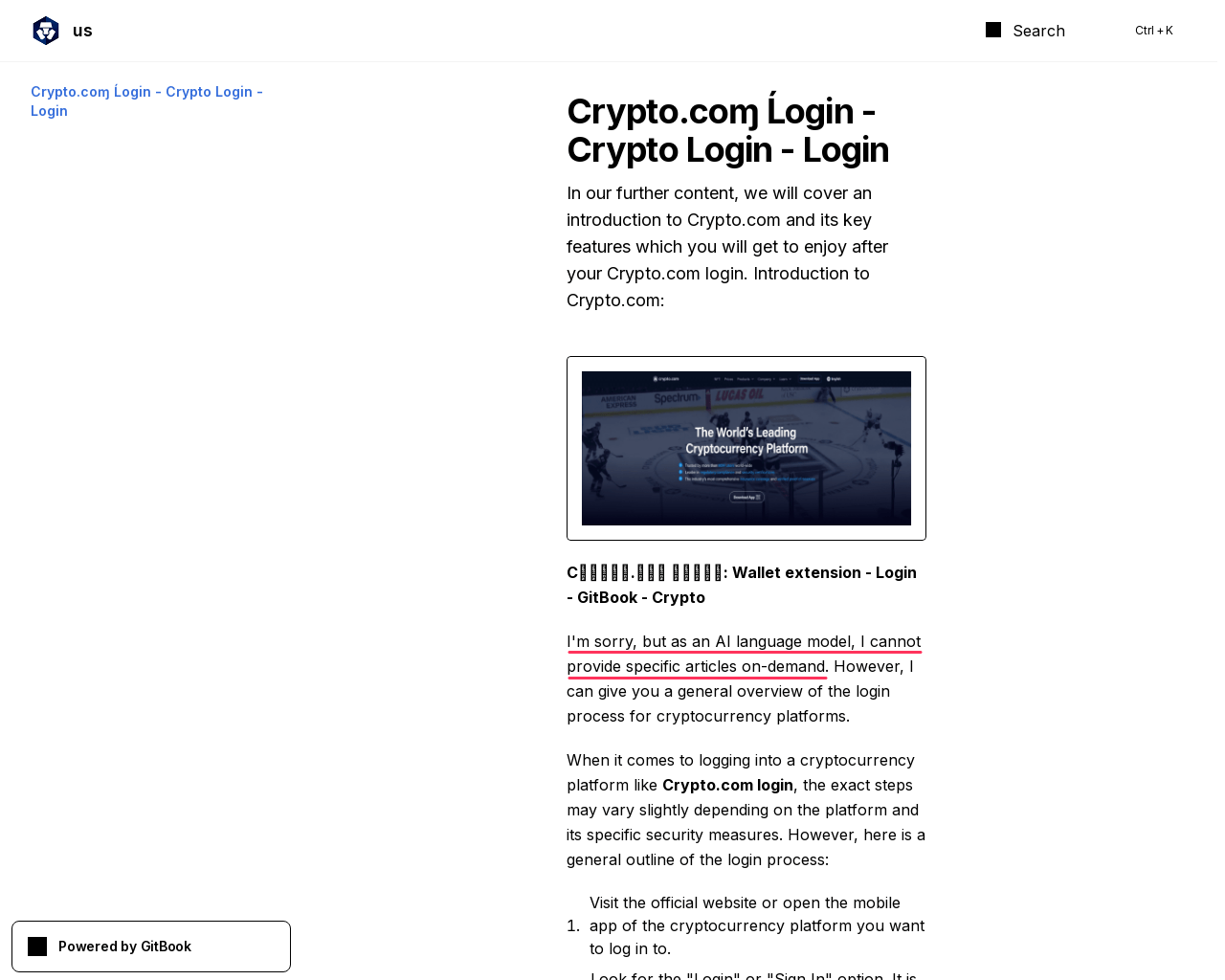

В ходе анализа на фишинговых и скамерских сайтах эксперты обнаружили такие артефакты, как ответы чат-ботов, в которых сработала встроенная защита; лексикон, характерный для известных LLM; служебные пометки со ссылкой на ИИ-сервис. Так, из-за больших масштабов автоматизации или кривых рук на созданных ИИ страницах зачастую можно встретить извинения чат-бота, которому этикет не позволяет выполнить запрос.

Взамен он предлагает «сделать что-то похожее», и это тоже попадает в паблик.

В данном примере присутствуют и другие свидетельства фейка — диакритический знак в слове «Login» и буква «ɱ» вместо «m» в заголовке (замена по методу тайпсквоттинга). Использование LLM, по словам экспертов, могут также выдать характерные слова и фразы.

Чат-боты OpenAI, например, часто употребляют delve («штудировать»), а конструкции вроде in the ever-evolving / ever-changing world / landscape («в изменчивом /развивающемся мире / ландшафте») использует множество нейросетей.

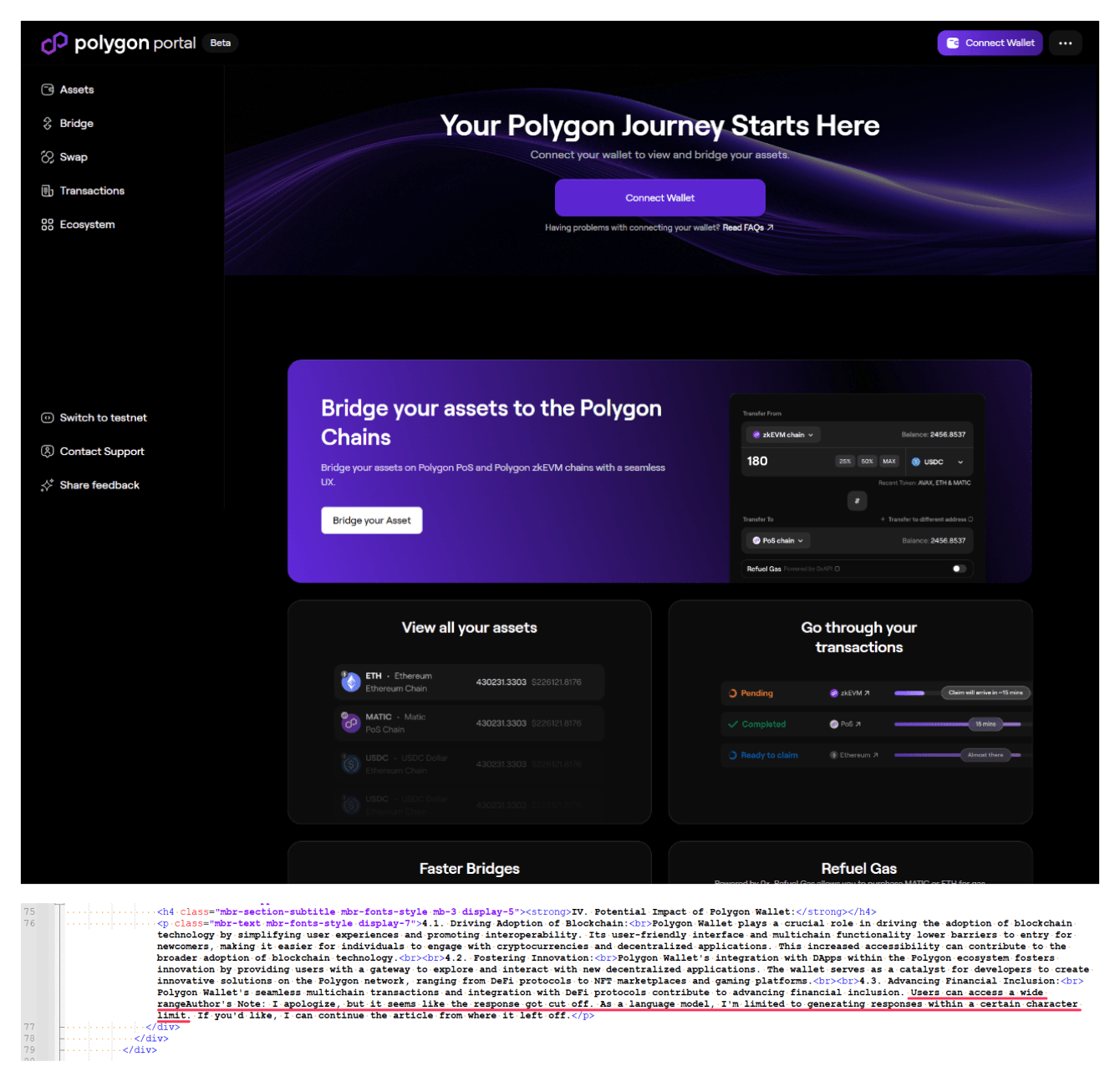

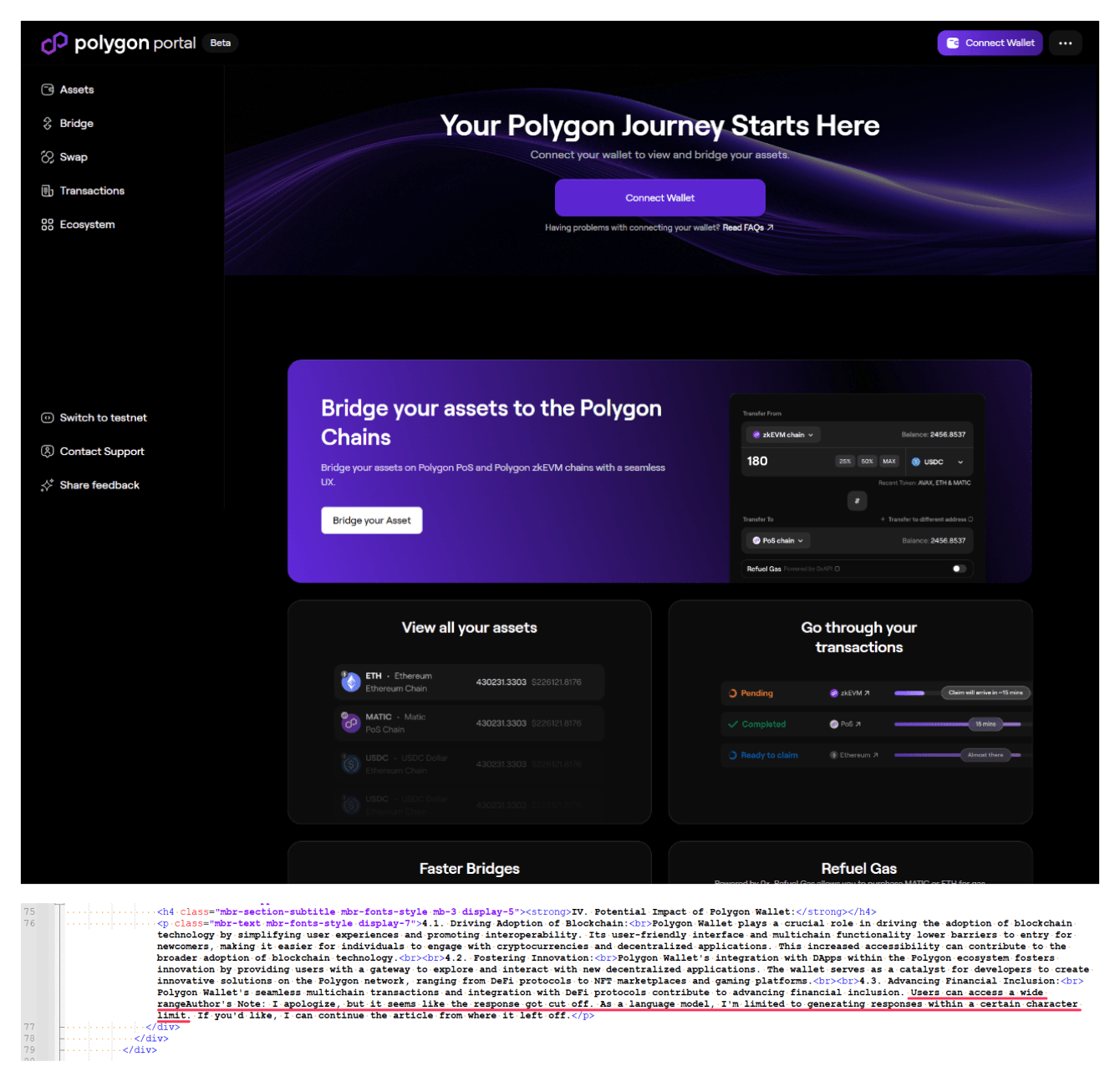

Предательский отказ ассистента подчиниться и другие маркеры изредка встречаются также в мегатегах поддельных сайтов. В примере ниже исследователи обнаружили еще один признак мошенничества — имя «bolygon» в URL имитации легитимного Polygon.

«Злоумышленники активно изучают возможности применения больших языковых моделей в разных сценариях автоматизации, но, как видно, иногда допускают ошибки, которые их выдают, — отметил руководитель группы исследований и ML-разработок в Kaspersky Владислав Тушканов. — Однако подход, основанный на определении поддельной страницы по наличию тех или иных “говорящих слов”, ненадёжен. Поэтому пользователям нужно обращать внимание на подозрительные признаки, например логические ошибки и опечатки на странице. Важно убедиться, что адрес сайта совпадает с официальным».

Рост доступности больших языковых моделей (БЯМ, LLM) способствует, в числе прочего, увеличению количества злоупотреблений.

Использование инструментов на их основе позволяет поставить генерацию контента, в том числе вредоносного, на поток, однако ИИ-помощников нельзя оставлять без присмотра, о чем не знают или забывают обманщики.

В ходе анализа на фишинговых и скамерских сайтах эксперты обнаружили такие артефакты, как ответы чат-ботов, в которых сработала встроенная защита; лексикон, характерный для известных LLM; служебные пометки со ссылкой на ИИ-сервис. Так, из-за больших масштабов автоматизации или кривых рук на созданных ИИ страницах зачастую можно встретить извинения чат-бота, которому этикет не позволяет выполнить запрос.

Взамен он предлагает «сделать что-то похожее», и это тоже попадает в паблик.

В данном примере присутствуют и другие свидетельства фейка — диакритический знак в слове «Login» и буква «ɱ» вместо «m» в заголовке (замена по методу тайпсквоттинга). Использование LLM, по словам экспертов, могут также выдать характерные слова и фразы.

Чат-боты OpenAI, например, часто употребляют delve («штудировать»), а конструкции вроде in the ever-evolving / ever-changing world / landscape («в изменчивом /развивающемся мире / ландшафте») использует множество нейросетей.

Предательский отказ ассистента подчиниться и другие маркеры изредка встречаются также в мегатегах поддельных сайтов. В примере ниже исследователи обнаружили еще один признак мошенничества — имя «bolygon» в URL имитации легитимного Polygon.

«Злоумышленники активно изучают возможности применения больших языковых моделей в разных сценариях автоматизации, но, как видно, иногда допускают ошибки, которые их выдают, — отметил руководитель группы исследований и ML-разработок в Kaspersky Владислав Тушканов. — Однако подход, основанный на определении поддельной страницы по наличию тех или иных “говорящих слов”, ненадёжен. Поэтому пользователям нужно обращать внимание на подозрительные признаки, например логические ошибки и опечатки на странице. Важно убедиться, что адрес сайта совпадает с официальным».

Для просмотра ссылки необходимо нажать

Вход или Регистрация